这两天,ChatGPT模型真可谓称得上是狂拽酷炫D炸天的存在了。

讲真,NLP这块,这两年把 Bert 引领的预训练 + finetune 的技术模式榨干之后,业界凉了许多。ChatGPT 真的是给 NLP 这堆快要烧尽的火又添了一桶油。

ChatGPT 确实非常牛逼,令很多人感觉到,人工智能模型分为两类———一类是ChatGPT,另一类是人工智障。

很多人都在讨论如下问题:

ChatGPT 会取代搜索引擎吗?

ChatGPT 是不是要让程序员都失业啊?

ChatGPT 出来了,google 和百度两家是不是要凉啊?

你看,还上热搜了:

趁大家都在兴头上,我来浇一盆凉水。分析一下 ChatGPT 到底有哪些不足?

如果还有小伙伴没有看过 ChatGPT 原理的,来看看这篇

大家在玩 ChatGPT 的过程中依然遇到了一些问题和现象

一、ChatGPT 突然就卡壳了

很多小伙伴在和 ChatGPT 交互过程中,会遇到模型突然卡壳的情况。个人认为,这可能是模型以一个极低的概率,输出了终止符导致的。

GPT-n系列模型都是基于自回归方式构建的,在输出对话结果的过程中,是依次按序输出每一个字符的,并设定了终止符<eos>,如果在某一个时刻,模型输出了该字符,则表明输出句子完毕。

毕竟,ChatGPT 依旧是基于概率统计原理构建的模型,必然存在一定极其微小的概率,突然就输出到了一个 <eos> 字符,导致终断输出了。

不过好在 ChatGPT 的多轮对话能力非常强大,只要给出继续的指令,它就能连续输出。

二、ChatGPT 出现了事实性错误

宫廷玉液酒我们都是知道,这是赵丽蓉和巩汉林的小品台词,用户在这里输入“宫廷玉液酒”,其意图也是想和 ChatGPT 对暗号,看看能不能说出“一百八一杯”,用来测试到底是不是中国大陆的人。

显然 ChatGPT 并没有理解这个对暗号的指示,而是把它当作一个概念解释进行展示了。这并不是事实上真实存在的中国白酒,所以, ChatGPT 已经在一本正经地胡说八道了。

换句话说,ChatGPT 模型无法分清真实和虚构。

它不知道宫廷玉液酒是什么,但是名字和其它一些中国白酒比较像,然后照猫画虎地编了一段白酒的介绍。

电线是谁发明的?

电线怎么成了图灵发明的了?这是事实性错误。

ChatGPT 模型可以马上改口反悔,说出正确的答案,电是特斯拉发明的。

这说明,模型训练过程中,语料确实包含了真实的、正确的信息的。但是在推理阶段,它还是犯错了。

而且这样的错误,伴随着大量的用户测试,也越来越多。大家发现它并不是一个100%稳妥可靠的知识库。

这基本可以得出结论:ChatGPT 无法完全替代搜索引擎。

它更适用于一些务虚的任务,比如写小说、写诗歌、搞辩论、写汇报材料、写公文材料(别打我)

三、ChatGPT 没有与实时信息的关联

ChatGPT 虽然有自我意识,但是信息更新停留在了 2021年,它无法连接搜索引擎,将最新、最实时的信息反馈给用户。

这同样说明,ChatGPT 无法替代搜索引擎。反而更适合作为搜索引擎入口的一个非常好的优化。

一般像 google 或者百度搜索引擎,需要用户自己输入搜索文字,然后自行浏览网页,找出答案。这个过程还有优化空间,也就是不要让人再找了,直接把结果反馈出来。

ChatGPT 有一个很好的功能,它可以润色文字。

ChatGPT 最适合的一个方向是,能够将搜索引擎上的信息润色、组织成最适合人阅读的形式,直接反馈给用户,而不用用户再去寻找哪一条搜索结果最适合。

所以可以得出结论,ChatGPT 非但不能替代 Google 和百度,反而,Google 和百度可以研发 ChatGPT 进一步优化搜索引擎,甚至可以把失去的搜索份额重新夺回来。

四、ChatGPT 没有思考能力

Google 前段时间有员工声称感觉到模型具备了意识。

这我感觉不应当叫做缺陷,因为它学习的并非真实的世界,而是那个 reward 模型。

模型并不理解什么叫小猫,也并不真正理解什么叫楼房。它没有触觉、没有知觉。

当然,它也无法观察世界,进行思考和创新。所以,我一直在想,什么时候,模型能够带上传感器,能够真实地感觉一下这个世界,那时的模型应该才能够有更加精准的意识。

甚至,带上一些人类不具备的传感器能力,比如,红外线和紫外线传感器,是不是就能够探知一些人类很难想象的另一个世界。

五、ChatGPT 的其它缺陷

我在知乎上看到有一些用户在苛责 ChatGPT 偶尔也会宕机,也会输出一些低质量的歌词、诗歌、小说等等。

这些缺陷并不是真正的困难和难点,个人认为是太过苛责 ChatGPT 了。

GPT-3 的局限性原因分析

一、有多少人工就有多少智能

在 ChatGPT 出来之前,NLP 业界可谓说已经到了一个冰点了。大家普遍都意识到了当前人工智能技术的一个巨大的缺点,那就是太过依赖标注数据。

比如,拿比较成熟的机器翻译模型为例,你没有上千万的双语预料对,那训练出来的模型是充满bug,不堪一用的。此外,语言是不断演化的,你的模型的语料也需要不断更新,以适应人们的需求。

再比如,天池平台上的 AI 竞赛,有非常多的比赛任务,数据量就只有几万条,几十万条。而任务本身又是极具挑战性的开放性问题,这就造成了很多参赛团队和选手都在一个很窄的赛道里拼命地卷。实在太缺数据了呀!!

人工标注数据,不论你标注了几百条,还是上百万条,抑或辛辛苦苦标了上亿条,只要你方法没变,依然是人工来做,那本质就没变。

这就类似于人力车和蒸汽机的区别,属于代差。

ChatGPT 虽然出产自 OpenAI——一家财大气粗的 AI 科技公司,该模型的最核心部分,也就是利用NLP+强化学习打造的奖励与惩罚reward模型,实际上也是由大量的人工进行标注训练的。

我喜欢将奖励与惩罚reward模型称为 reward 母体,因为和《黑客帝国》里的 母体 matrix 的概念、作用太相似了。

ChatGPT 模型的能力上限,很大程度就是由这个 reward模型决定。它的拟合能力越接近真实的世界,ChatGPT 也就越能够完成令人惊艳的推理、判断、感知操作。

就像我们需要巨量的语料去完成机器翻译任务一样,reward模型也同样需要巨量的语料来拟合真实世界。这个代价是十分巨大的。

reward 模型拟合不好的地方,就是人们观察到 ChatGPT 模型效果糟糕的地方。那是下一个缓慢爬坡的过程。

二、对标注人员的高要求

惯常认知里,AI模型的数据标注员是个低端的职业。制作一个猫狗分类器,标注员的主要工作就是对每一张图片包含了猫、还是狗进行一个分类,小学生都能做。

然而,ChatGPT 模型里,它所能完成的工作甚至达到了,做高等数学题这种程度。模型输出的结果是否真实可靠,需要reward模型进行评价和反馈。这时候,如果数据标注员没有高等数学知识,我想很难保证模型的精准。

有人猜测,ChatGPT吸纳了 Stack Overflow 里大量的优质答案作为数据,但 Stack Overflow 本身也是由人工一点点构建起来的巨型大厦。

高要求,也就意味着,评价困难。模型质量的提升也较为困难。

三、再大的模型也不是无限

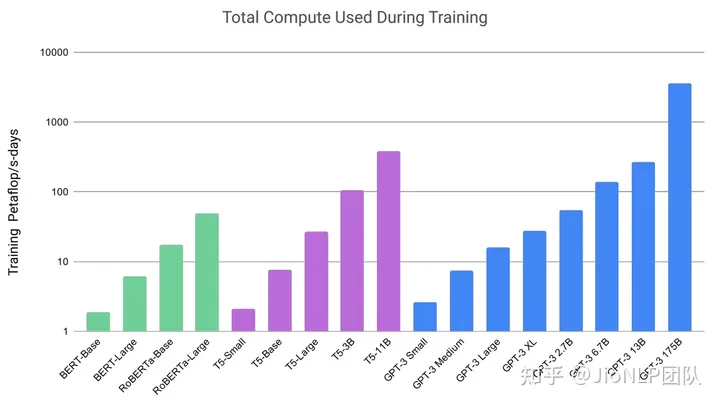

GPT-n 系列模型一代比一代大,从最早大家觉得几个亿的参数和几个G 的文本数据量就叫大模型。到了现在,GPT-3 和 3.5 里,模型参数达到了上千亿,数据量也达到了上万亿规模。

我们也看到了 ChatGPT 里并非存得下全世界的所有知识,而用户提问则是对全世界所有知识的一个采样,那绝对是一个无限的范围。

吾生也有涯,而知也无涯。以有涯随无涯,殆已!

换在模型上,则是:

模型也有涯,而知也无涯。以有涯随无涯,殆已!

作为一个模型,能够做到这种程度,我必须给100分,因为它已经克服了太多的 NLP 之前的难题,诸如多轮对话的连贯性、指代消岐、讽刺、正话反说等等。

我们夸一个小孩聪明,只需要他回答出一个精彩的答案;我们夸一个模型牛逼,却需要它方方面面都给出精彩的答案。

毕竟 ChatGPT 只是一个有限的模型,它不是全宇宙知识汇聚的神。不能要求它掌握全世界知识,一旦出错就把 ChatGPT 贬为人工智障。

但确实,一个需要发展的方向是,如何让模型能够持续更新知识,查询知识。牵着搜索引擎和互联网的牛鼻子,而非把整头牛都抱在怀里。

(欢迎关注我的公众号JioNLP,一个NLP抱团取暖的地方,开源软件JioNLP 在Github,目前star数1.7k)