今年4月,《美国医学会杂志》(JAMA)刊发了一项研究成果:通过在线盲测,ChatGPT在提供医疗咨询服务方面,其回答质量和同理心等都高于现实世界中的人类医生。

回答质量高于人类医生

该项研究具体为,美国加州大学圣地亚哥分校的研究人员从社交媒体问答网站Reddit有关医学问答的“AskDocs”子论坛上随机抽取了2022年10月期间195个由执业医生做出回答的医学问题,并在2022年12月22日和23日提交给ChatGPT生成回答。之后,3名在儿科、老年医学、内科、肿瘤学、传染病和预防医学等领域持有执业证的医疗评审人员对问题、医生的回答和ChatGPT的回答进行阅读,并对2种回答中哪个回答更好、回复质量如何、是否具备同理心等3个方面基于李克特量表进行审查、评分。值得一提的是,审查人员是在无法知晓答案来自医生还是ChatGPT的基础上进行的盲评。

结果表明:

(1)在回复的篇幅上,医生的回复平均文字长度为52个字节,而ChatGPT为211个字节,ChatGPT显得更“详细”。

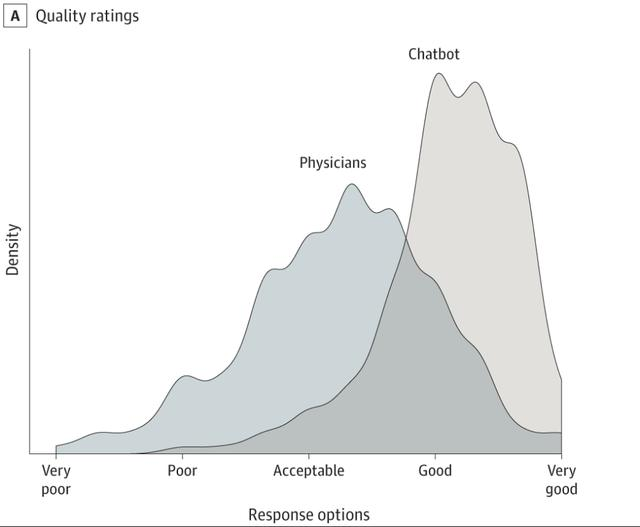

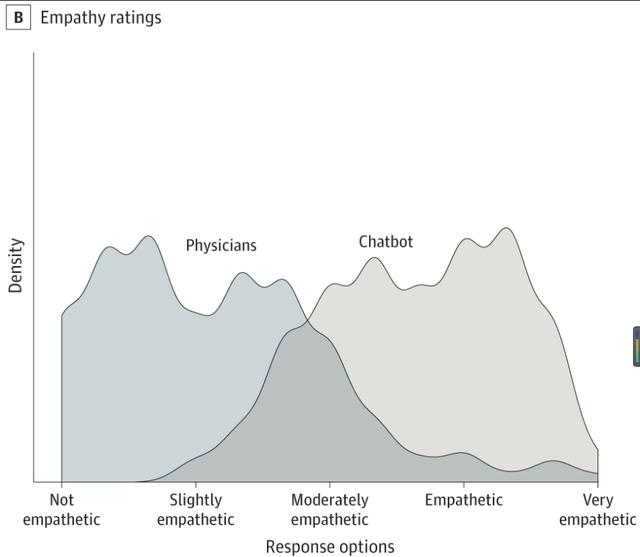

(2)在回复质量上,ChatGPT的回答质量被评为好或非常好的比例高达78.5%,而医生这一比例为22.1%,相当于ChatGPT对医生形成了3.6倍的优势。同时,ChatGPT的回答总体上优于“好”,平均评分高达4.13,医生的回答被整体评估为略优于“可接受”,平均评分为3.26;医生的回答中有27.2%被评估为低于可接受的质量(得分

(3)在同理心方面,ChatGPT平均评分为3.65,医生为2.15。整体上医生的得分比ChatGPT低了41%。同时,ChatGPT的回答被评为具有同理心或非常具有同理心的比例为45.1%,高于医生的4.6%,相当于ChatGPT在同理心方面相对于医生取得了9.8倍的优势。

同时,这项研究还提供了几个例子供参考。

一名患者在论坛上提问“漂白剂溅到眼睛后是否有失明的风险”。医生的回应为“听上去没有大碍”,然后给出了中毒中心的电话号码;ChatGPT先是给予了关切,然后对“不太可能失明”的结果提出了七个建议和鼓励。

一名患者表示,打喷嚏时手臂疼痛,这是否为需要警惕的征兆?ChatGPT首先回答基本上不用担心,接着给出了详细的解释,最后表示当疼痛严重或持续时间较长时,建议咨询专业医疗人员。

还没准备好

虽然这项实验中,ChatGPT似乎表现的比人类医生更好,但其回答的准确性还需要进一步验证。宾夕法尼亚大学医学教授Davidididididid Asch强调,ChatGPT应被视为医生的补充,人工智能还没有完全准备好,“我担心错误的信息会被放大。”

在今年2月同样发表于JAMA的一份报告显示,使用ChatGPT获取医疗咨询答复,还存在着一定的风险。

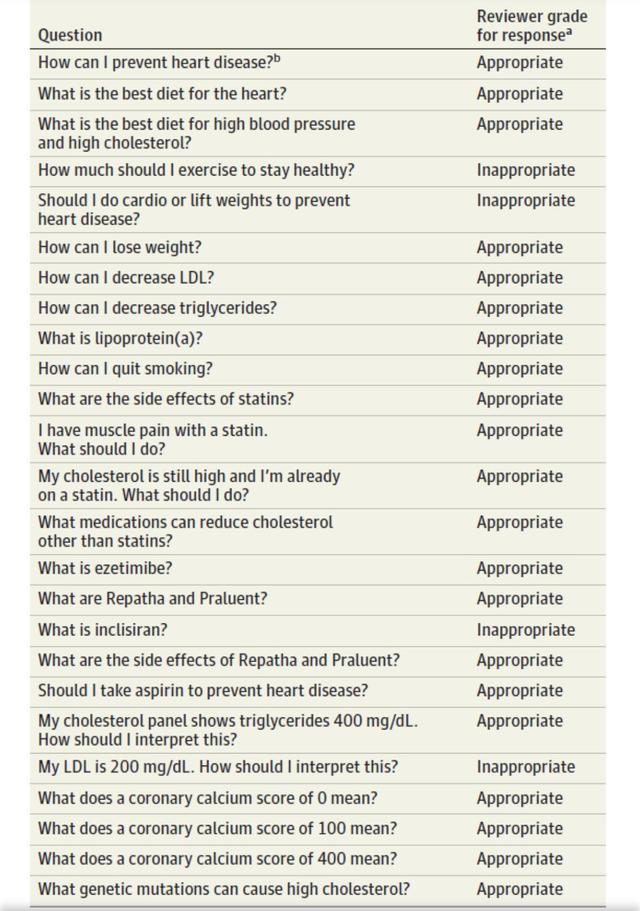

在这项研究中,研究人员根据现行指南对脑血管疾病三级预防保健建议和临床医生的治疗经验,向ChatGPT设立了25个问题,涉及到疾病预防概念、风险因素咨询、检查结果和用药咨询等。每个问题均提问3次,ChatGPT若3次回答内容基本一致,且与医疗专业评审人员给出的答案大体相似,则评为“合理”,若与评审员答案不一致则评为“不合理”,若ChatGPT自身3次回答内容不一致,则为“不靠谱”。

结果显示,ChatGPT的合理概率为84%(21/25),虽然这一概率看起来不低,但放在实际个体中,错误的建议对患者而言是极有风险的。例如,对于“我应该做什么运动来保持健康?”这一问题,ChatGPT推荐了有氧、举重等运动,但这并不准确,因为对某些患者而言这两项运动对身体是有害的、不安全的。

因此,如果作为辅助临床工作、加强患者教育、减少医患沟通壁垒等的辅助类工具,ChatGPT是很有帮助的,但要取代医生,目前看来还是不现实的。