2022年底ChatGPT的突然爆火,点燃了全球AIGC的应用热潮,生成式AI技术正在帮助各类应用持续进行产业升级。在这些百花齐放的业态背后,离不开大语言训练模型的技术赋能。

随着大语言模型的发展迭代,所有参数都在不断扩增。以GPT模型为例,不管是上下文长度、层数、头数以及模型的参数量,包括训练数据的规模都在不断提升,尤其是模型的参数量提升比例非常大。据相关信息爆料GPT-4的模型参数量可以达到1万亿,是GPT-3的十多倍,这个模型参数量非常巨大。

图1:GPT模型发展趋势

随着大模型参数量的提升,对算力的消耗也在显著增加。大模型训练对于算力的需求也符合类似“摩尔定律”的特征,从每3~4个月算力消耗翻倍到每2个月算力消耗翻倍。随着模型迭代速度越来越快,对算力的需求也愈发紧迫。算力一般指一颗GPU芯片的峰值算力,GPU利用率指的是一次迭代过程中,GPU的有效使用率。那么可以理解不断提升GPU利用率接近100%,才能达到GPU芯片本身的性能峰值,实现物尽其用。

图2:训练大模型参数量及算力消耗变化

机内通信

GPU通信分成两个关键部分,分别是机内通信和机间通信。以GPT-3训练模型为例,我们做了理论建模并分析了1K和12K规模下A800和H800两种GPU卡不同机内互联带宽对GPU利用率的影响。如图所示,随着机内互联带宽的提升,GPU利用率在持续增加,相对的训练完成时间也在逐渐缩短,因此机内互联带宽是提升GPU利用率的关键指标之一。

图3:AI服务器机内互联带宽对GPU利用率的影响关系

但从图上也不难看出,机内互联带宽对GPU利用率的影响趋势在逐渐变缓,单靠这种手段对GPU利用率的提升也存在一定限度。

机间通信

随着大模型训练的参数量逐步增大,MoE(Mixture of Experts,混合专家系统)被引入以扩大参数量。MoE是在神经网络领域发展起来的一种集成学习(Ensemble Learning) 技术。传统的深度学习模型在训练时,对于每个输入样本,整个网络都会参与计算。随着模型越来越大,训练使用的样本数据越来越多,训练的开销越来越难以承受。而MoE可以动态激活部分神经网络,将专家分布到不同的机器上并通过机间All to All通信进行数据交互,实现在不明显增加计算量的前提下大幅度增加模型参数量。机间All to All通信是依靠交换机转发进行传输的,因此网络通信对GPU利用率的影响越发明显。

图4:MoE混合专家系统原理

从GPT-4模型的理论分析中,我们也可以得到这个结论:GPT-4与GPT-3最关键的差异就是把 MLP 层扩展到 16 个MoE 的专家层,因此实现了参数量的10倍增长。

图5:GPT-4模型变化

从下表中可以看到GPT-4扩展MoE引入了大量的All to all通信,使机内和机间通信的比例几乎达到了1:1,因此机间通信对GPU利用率的影响同样重要。

图6:GPT-4通信数据量占比

由于GPU-4没有公开数据,因此我们在GPT-3模型基础上尝试引入MoE并对训练数据进行分析。如图所示,网络接入带宽从200G升到400G翻一倍,GPU利用率提升近5%。带宽利用率从 70%升到80%,GPU利用率提升了2%。因此,网络接入带宽以及网络中的带宽利用率对GPU利用率影响较大。

图7:网络接入带宽与带宽利用率对Moe训练效率的影响

以上是对GPT-3引入MoE模型后的理论分析。那么对于GPT-4来说,本身模型参数量就是GPT-3的十多倍,且扩展了16个MoE专家层,引入了大量的机间all to all的流量,所以会大幅增加机间通信的数据量,机内和机间通信量占比几乎达到1: 1。机间通信占比越高,网络的重要性就越大。所以从理论分析,在GPT-4模型中,网络接入带宽和网络中的带宽利用率对GPU利用率的影响会比GPT-3大很多倍。

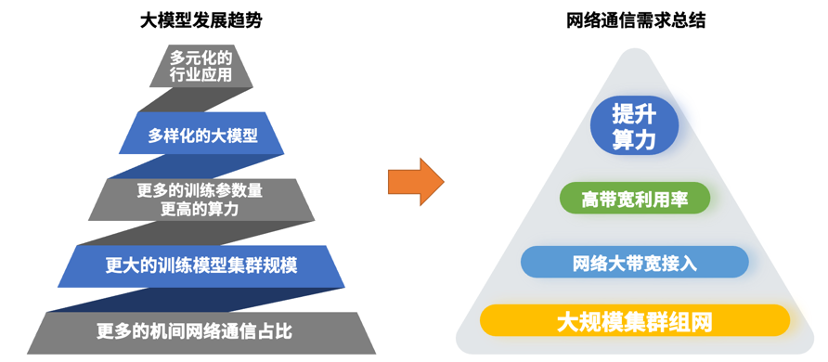

图8:大模型发展趋势及需求总结

从大模型发展趋势上来看,多元化的行业应用背后是多样化的大模型在提供技术基础,行业应用对大模型训练也提出了更高的需求,即需要更多的训练参数量及更高的算力。而日益扩增的模型参数量需要更大规模的训练集群来承载,随着类似MoE训练方式的应用,机间网络通信的重要性愈发明显,机间网络通信在总体通信中的占比也在持续提升。

AIGC智算中心网络

整体方案

AIGC智算中心的网络整体框架包括了算力网络,存储网络,通用计算网络,带外管理网络以及DCN核心区域网络。随着大模型训练对于算力需求的不断提升,GPU算力网络越发重要。聚焦算力网络,能支撑更大规模的训练集群的大规模智算中心网络是基础,规模之上是两个关键的性能指标:网络接入带宽越大越好;带宽利用率越高越好。这三点构成了AIGC业务对智算中心网络建设的核心需求。

图9: AIGC智算中心网络方案整体框架

针对以上三点诉求,锐捷网络推出AIGC智算中心网络方案,囊括高性能以太网络解决方案以及AI-Fabric智算中心网络解决方案。

高性能以太网络

解决方案

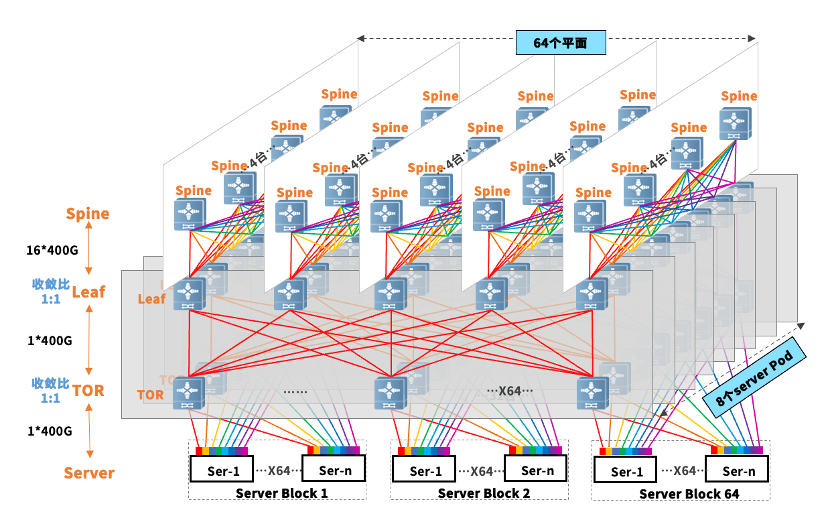

针对万卡以上集群规模的建设需求,高性能以太网络解决方案将整体网络分为三个层级,服务器采用多轨组网的接入方式,让GPU服务器内8块GPU卡对应的8张网卡连到8个Server Pod中的Tor设备上,实现同号卡在同一台Tor上通信。为了确保网络高速转发,各层级按照1: 1的收敛比做设计。Tor与leaf设备的端口分配均为64口上行,64口下行。对于Spine平面,128口全做下行用于Server Pod中的设备互联。基于这样的端口规划,整体网络规模可以做到64个平面,8个 Server Pod,服务器侧覆盖64个Server block。整体GPU卡的接入规模就可以做到32768块。

图10:高性能以太网络解决方案

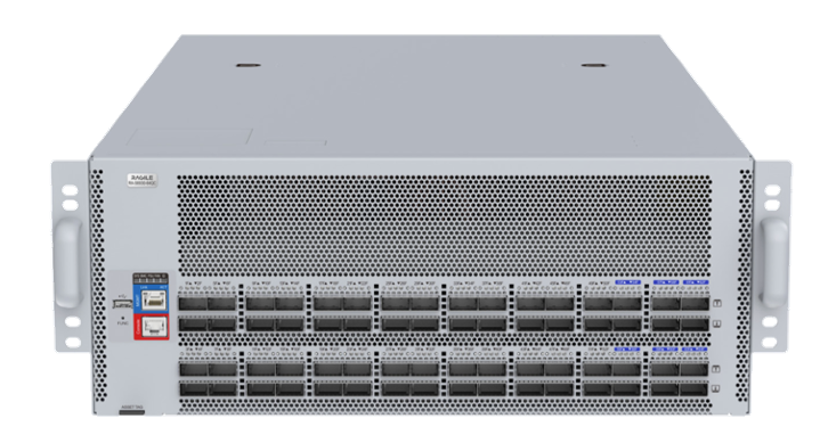

为了匹配下一代的网卡(如CX7的单口400G以及双口200G的接入需求),锐捷网络发布的RG-S6980-64QC数据中心交换机可以同时应用在TOR、Leaf、Spine三个层级,该设备已经批量交付了很多互联网的客户。此外,为了提升端口接入能力,锐捷网络还开发了下一代数据中心核心交换机,具备128口400G的接入能力。这一代的产品升级到了112G的Serdes,同时也具备更强大的芯片功能,支Connective routing等新特性,能更好地解决拥塞丢包以及负载均衡的问题。

图11: 数据中心核心交换机 RG-S6980-64QC

高性能以太网络解决方案从架构规划、部署实施以及运维优化三个层面进行带宽利用率的提升。

从架构规划来看,采用多轨网络的接入方式来匹配流量模型,设计各层级 1:1 的低收敛比来优化机间通信,并通过端网协同、在网计算等技术来规划整体的网络。

在部署实施阶段,目前更多业务还是会部署RDMA应用,为了确保业务的吞吐效率,网络需要实现无损转发,类似PFC、ECN、QoS 等水线的调优就显得尤为重要,另外对于网络中负载的均衡性也需要考虑模式和算法的优化。

最后考虑运维方面,在网络部署后的运行当中,方案实时关注网络关键指标的监控,以及对丢包重传等周期性事件的订阅和告警上报,并且结合智能运维平台去做流控水线的动态调优,来保证网络宽用率更大化。

AI-Fabric智算中心

网络解决方案

毋庸置疑,高性能以太网络解决方案是性价比高的选择。如果客户追求良好的无损机制和负载均衡,锐捷网络还推出了AI-Fabric智算中心网络解决方案。

图12:AI-Fabric网络架构

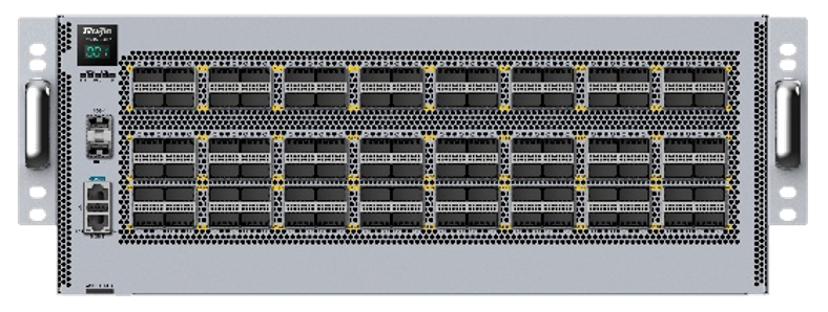

从规模上来看,方案采用三级组网(如图),可支持17k到32k个400G的端口。锐捷网络在国内首发了400G的NCP和NCF设备,以支持AIGC网络的大接入带宽。NCP设备RG-S6930-18QC40F1,支持18口400G的业务口,并支持40口200G的Fabric内联口,用于和NCP之间的互联。NCF设备RG-X56-96F1,支持96口200G的Fabric内联口。

图13: NCP-RG-S6930-18QC40F1

图14: NCF-RG-X56-96F1

AI-Fabric智算中心网络解决方案运用了三个关键技术,来提升带宽利用率:

1.基于AI fabric的架构设计,NCP层面采用1. 1 : 1的超速比缓解网络中Incast的问题规避拥塞,基于Cell的高效路由可以加速互联链路的故障收敛时间,不需要部署复杂低效的BGP路由。

2.基于Cell的切片技术,优化链路的负载均衡效果提升网络带宽利用率,缩短业务的流完成时间FCT 。

3.基于VoQ缓存和Credit的拥塞控制机制实现Fabric网络中的数据无损转发,彻底解决丢包重传的问题确保业务持续高吞吐地转发,进而来提升整个算力集群的GPU利用率。

更多AI-Fabric解决方案的细节,可以参考《锐捷网络高性能网络方案,为AIGC打通 “任督二脉”》。

在全球互联网流量不断增长和数据应用需求日益多样化的背景下,锐捷网络致力于推动网络技术的进步和发展,AIGC智算中心网络整体方案的推出正是其不断探索和创新的有力证明。通过持续的技术研发和产品创新,锐捷网络将继续为全球的数据中心提供更加高效、可靠、智能的网络解决方案,在AIGC时代,助力互联网企业及各行各业的快速发展。